6. make_vector_store 명령 수정¶

변경 파일을 한 번에 덮어쓰기 하실려면, pyhub-git-commit-apply 유틸리티 설치하신 후에, rag-02 폴더 상위 경로에서 아래 명령어 실행

uv run pyhub-git-commit-apply https://github.com/pyhub-kr/django-llm-chat-proj/commit/bf9de8db17040a7301593f8e54bae3cfc6986b9e

6.2. 개선 포인트¶

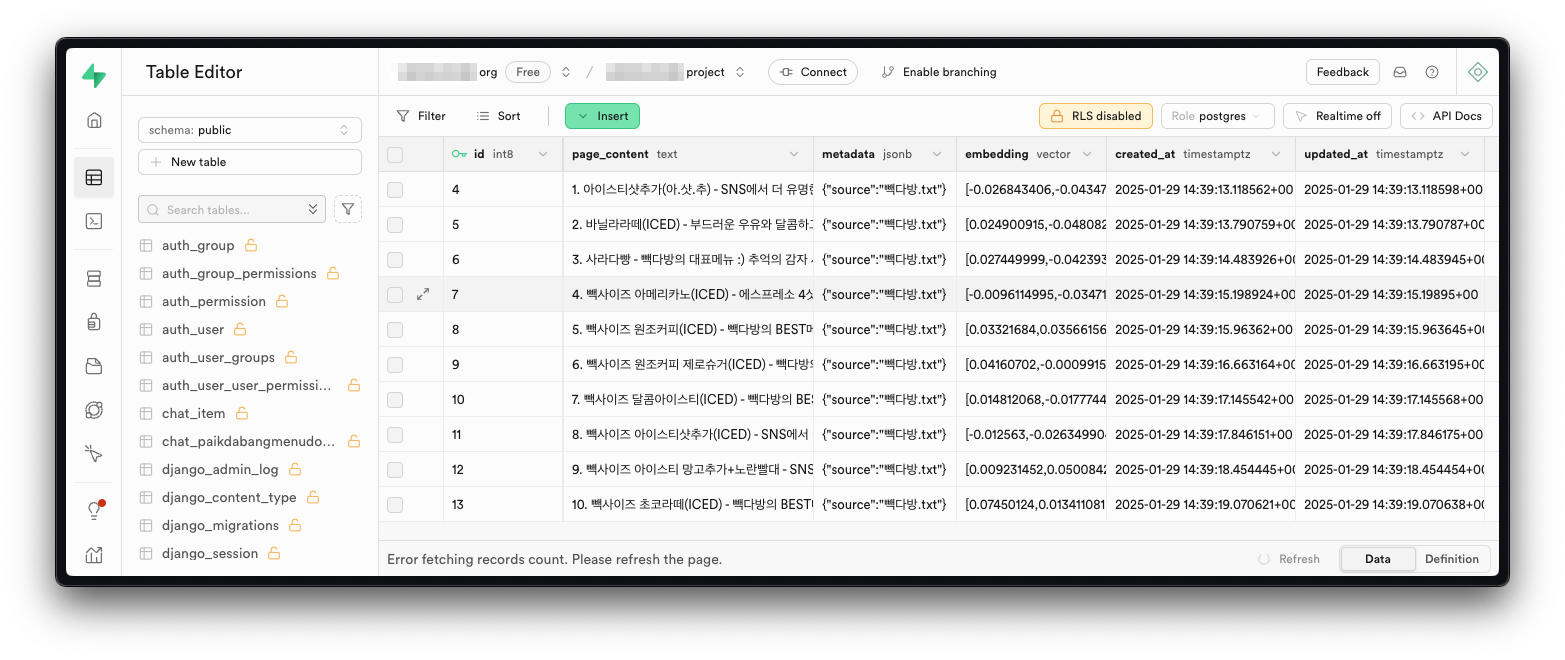

현재 코드는 각 PaikdabangMenuDocument 인스턴스마다 개별적으로 OpenAI Embedding API를 호출하고,

개별적으로 데이터베이스에 저장하고 있습니다. 이로 인해 다음과 같은 비효율이 발생합니다.

비효율적인 데이터베이스 삽입

각 문서마다 개별적으로 INSERT 쿼리를 실행하기보다, 여러 개의 INSERT 쿼리를 하나의 배치로 묶어 실행하면 트랜잭션 오버헤드를 줄이고 성능을 최적화할 수 있습니다.

API 호출 횟수 증가

각 문서마다 개별적으로 Embedding API를 호출하기에 네트워크 요청이 과도하게 발생합니다. 여러 개의 문서를 한 번의 API 요청으로 처리하면 전체 처리 시간을 단축할 수 있습니다.